Otros Productos Digitales

Tabla de Datos (Excel) con 10 Artículos Científicos

Descripción: Este proyecto analiza de manera descriptiva los desafíos éticos que surgen al usar herramientas de inteligencia artificial para detectar plagio en trabajos universitarios. Hemos recopilado 10 artículos científicos en una tabla de Excel, sistematizando temas como sesgos lingüísticos, privacidad de datos, transparencia y necesidad de supervisión humana.

📥 Descargar tabla de 10 artículos (Excel)Protocolo de Investigación: Implicaciones éticas de la detección automatizada de plagio en la educación universitaria

Descripción: Este protocolo de investigación presenta un análisis integral de las implicaciones éticas derivadas del uso de herramientas automatizadas para detectar el plagio en entornos universitarios. Se examinan aspectos críticos como la equidad, los sesgos algorítmicos y la transparencia en los criterios de evaluación, a partir de una revisión bibliográfica y documental que sistematiza la evidencia disponible. El estudio busca no solo comprender los retos actuales en la implementación de estas tecnologías, sino también proponer lineamientos innovadores que fortalezcan la integridad académica y promuevan prácticas éticas responsables en la evaluación de trabajos universitarios.

Consulta el Doc. Completo de la propuesta de investigación: 📥 Descargar propuesta de investigación completo (PDF)

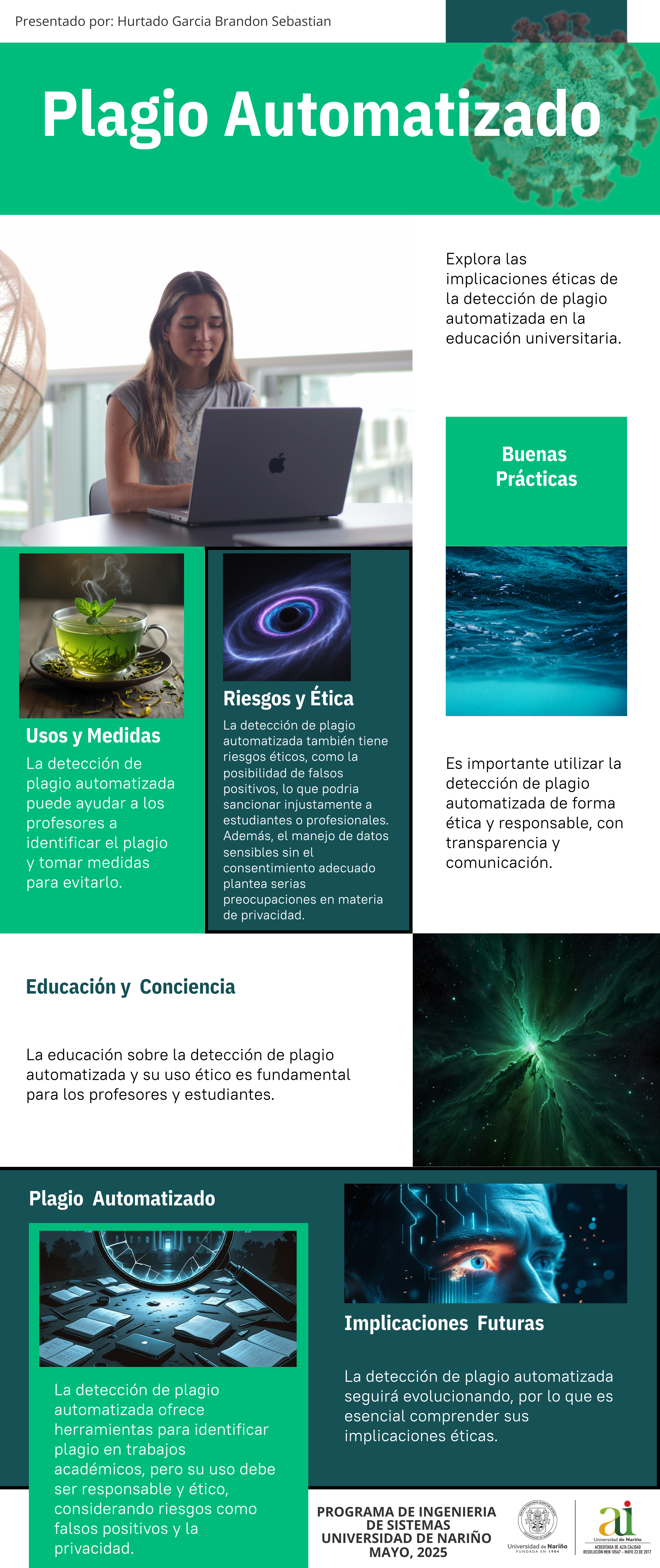

Infografía Interactiva (vista previa)

Repositorio en GitHub

Clona nuestro repositorio para obtener todo el código fuente, estilos y documentos de apoyo:

🔗 github.com/brandonsh9/infograf-a-plagio-iaAutor: Brandon Sebastián Hurtado García (bhurtadog20a@udenar.edu.co)